Eksplozja danych pozostanie największym wyzwaniem dla branży IT w 2013 roku, a tematem numer jeden staną się duże zbiory danych. Specjaliści IT zaczną dyskutować o eksabajtach, a petabajty staną się nowym standardem w dużych magazynach danych.

Uwagę ekspertów zwrócą również wtórne dane związane z kopiami zapasowymi oraz starsze dane, które nie są pilnie potrzebne, lecz zużywają znaczną część budżetu IT na retencję i utrzymanie. Pracownicy będą używać wielu inteligentnych urządzeń do tworzenia informacji poza centrum danych, co zwiększy produktywność, ale przysporzy nowych problemów działom IT. Wychodząc z takich założeń Hu Yoshida, Chief Technical Officer w Hitachi Data Systems przygotował listę trendów na 2013 rok, które w istotny sposób wpłyną na działy IT w firmach i organizacjach publicznych.

1. Radykalne zmiany wydatków operacyjnych i kapitałowych

Przez 10 minionych lat łączny koszt użytkowania pamięci masowej zwiększał się o około 7 proc. rocznie, podczas gdy jej pojemność rosła o 30-40 proc. Wzrost kosztów związany był głównie z wydatkami operacyjnymi (OPEX), podczas gdy wydatki na sprzęt (CAPEX) pozostawały względnie stabilne. Technologie dyskowe rozwijały się w dynamicznym tempie — gęstość zapisu podwajała się co 18-24 miesiące, przez co ceny dysków spadały o około 30 proc. rocznie. Do ograniczenia kosztów sprzętu przyczyniły się również sieci pamięci masowej (Storage Area Networks, SAN), które wyeliminowały pamięć podłączaną bezpośrednio (Direct Attached Storage, DAS) i pozwoliły lepiej wykorzystać sprzęt poprzez konsolidację. Sieć SAN wprowadziła jednak kolejny poziom zarządzania i złożoności, tym samym zwiększając koszty operacyjne. W miarę, jak coraz więcej aplikacji i danych współdzieli większe systemy pamięciowe, coraz trudniejsze staje się zarządzanie harmonogramem kopii zapasowych, utrzymania i migracji.

Powyższe trendy w kosztach CAPEX i OPEX niebawem radykalnie się zmienią. Dobra wiadomość jest taka, że wirtualizacja serwerów i pamięci masowej ma znaczący wpływ na koszty operacyjne i odwraca trend wzrostu OPEX. Technologie wirtualizacji pamięci masowej opracowane przez Hitachi Data Systems ograniczają łączne koszty użytkowania (TCO) o 40 proc. lub więcej i zwracają się w niespełna rok. Z drugiej strony CAPEX, czyli koszty sprzętu, zaczynają narastać, ponieważ coraz więcej funkcji jest realizowanych sprzętowo, a popyt na pojemność rośnie lawinowo w związku ze zjawiskiem Big Data oraz potrzebą przechowywania danych przez nieokreślony czas. Jednocześnie technologie zapisu rozwijają się w wolniejszym tempie.

Prognozuje się, że erozja cen pamięci masowej będzie wynosić tylko 20 proc. rocznie do 2020 roku.

2. Kupowanie pamięci masowej w miarę potrzeb

Bieżący model konsumpcji pamięci masowej przekłada się na jej wysoką pojemność, za którą klienci płacą, ale której mogą nigdy nie wykorzystać. W przeszłości, kiedy koszty sprzętu były niskie w porównaniu z kosztami operacyjnymi, kupowanie pojemności na zapas miało sens, jeśli powodowało obniżenie wydatków operacyjnych. Jednak dzisiaj, kiedy popyt na pamięć rośnie przy wolniejszym spadku ich cen, warto ponownie zastanowić się nad stosunkiem kosztów CAPEX i OPEX.

Na początku nowego cyklu produktowego działy IT kupują całą pojemność, której mogą potrzebować przez 4 czy 5 kolejnych lat po najlepszej aktualnej cenie. Znaczna część tej pojemności pozostanie niewykorzystana; kupiono ją na wszelki wypadek, gdyby była potrzebna przed następnym cyklem modernizacji. Kupowanie pamięci z góry było bardziej ekonomiczne, ponieważ instalowanie, formatowanie, tworzenie grup RAID i definiowanie jednostek LUN przy każdym zakupie zwiększałoby koszty operacyjne. Ponadto rozszerzenia dokupione dwa lub trzy lata po rozpoczęciu cyklu produktowego straciłyby na wartości przy kolejnej modernizacji technologii, a administracyjny proces nabywania każdego rozszerzenia zajmowałby cenny czas. Przejście na pamięć masową nowej generacji było kosztowne, ponieważ w trakcie migracji musiała być dostępna zarówno stara, jak i nowa pamięć, a po zakończeniu jednej migracji niemal przychodził czas na następną.

Hitachi uważa, że nadszedł czas, aby zmienić ten model konsumpcji. Zamiast nabywać całą pamięć na 4 lub 5 następnych lat po dzisiejszych cenach, należy kupować ją w miarę potrzeb. W tym celu trzeba dysponować kilkoma podstawowymi technologiami:

• możliwością dynamicznego alokowania zasobów dyskowych;

• możliwością płynnego migrowania danych ze starej pamięci do nowej;

• oraz możliwością zwirtualizowania zasobów podczas przechodzenia na najnowszą technologię.

Technologie te są dziś dostępne w rozwiązaniach Hitachi Data Systems. Potrzebne będą też pewne narzędzia finansowe, ponieważ ktoś nadal musi ponieść koszty kapitałowe. Usługi

w chmurze, takie jak „infrastruktura jako usługa” (IaaS), outsourcing ośrodków przetwarzania danych oraz usługi zarządzane, umożliwiają przejście na bardziej efektywne modele wykorzystania „na żądanie”, które ograniczają TCO i przekształcają CAPEX w OPEX.

Gartner zgadza się z tym trendem i prognozuje, że w 2013 roku 25 proc. wydatków na infrastrukturę będzie rozliczanych za jednostkę wykorzystanej przestrzeni.

3. Rosnące wykorzystanie platform zarządzania treścią do archiwizacji i udostępniania danych

Dzięki wirtualizacji wiele serwerów aplikacyjnych może działać na tym samym fizycznym serwerze i współdzielić zasoby pamięciowe. Dane aplikacji pozostają jednak zamknięte w oddzielnych „silosach”. Aby zapewnić skonsolidowany wgląd, musimy zwirtualizować, czyli odłączyć dane od aplikacji z wykorzystaniem platform zarządzania treścią. Platforma zarządzania treścią może przyjmować dane od różnych aplikacji za pośrednictwem standardowych protokołów, takich jak HTTP lub NFS, wraz z metadanymi, które opisują zawartość danych. Metadane pozwalają wyszukiwać dane i uzyskiwać do nich dostęp niezależnie od aplikacji, która je utworzyła. W 2013 roku coraz więcej użytkowników zacznie korzystać z platform zarządzania treścią, takich jak Hitachi Content Platform (HCP). Platformy te mogą przechowywać dane aplikacji w pojedynczym repozytorium wraz z metadanymi, które umożliwiają interpretację zawartości. Pozwala to wspólnie przeglądać, udostępniać i analizować wspólne punkty danych od różnych aplikacji, aby sprawniej podejmować decyzje biznesowe. Platformy zarządzania treścią można również wykorzystać jak aktywne archiwum na dane statyczne.

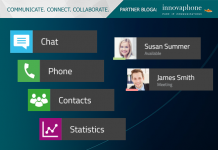

4. Bezpieczna platforma do obsługi urządzeń mobilnych

Upowszechnienie się urządzeń mobilnych i trend BYOD (czyli używanie urządzeń osobistych do celów zawodowych) radykalnie zmieni miejsce pracy, prowadząc do większej kreatywności i innowacyjności społecznościowej. Według raportu iPass 2010 Mobile Workforce, pracownicy z urządzeniami mobilnymi pracują o 240 godzin dłużej w skali roku, co przekłada się na sześć dodatkowych tygodni pracy na rok na jedną osobę. Urządzenia mobilne pozwalają łączyć życie osobiste i zawodowe oraz pozostawać w kontakcie w każdym miejscu i o każdej porze. Aby działy IT mogły uwzględnić ten trend i wykorzystać zalety technologii, muszą zapewnić odpowiednią przepustowość i bezpieczną infrastrukturę do udostępniania informacji między urządzeniami oraz zarządzania cyklem życia tworzonych danych. W 2013 roku upowszechnienie się urządzeń mobilnych zwiększy popyt na platformy zarządzania treścią, a producenci skupią się na rozwiązaniu problemów z bezpieczeństwem oraz na kosztach wdrażania urządzeń mobilnych. Dzięki temu firmy zaoferują bezpieczną platformę dostępu do treści, która może być kontrolowana i zarządzana przez dział IT.

Hu Yoshida, Chief Technology Officer

Hitachi Data Systems